Ersetzt berta & rudi Energieingenieur:innen?

Ersetzt GPT berta & rudi?

Wer ersetzt hier eigentlich wen? Ich sehe nicht mehr durch.

Ja, genau. So weit ist es gekommen… Es geht nicht mehr nur darum, dass Ingenieur:innen durch KI beziehungsweise Software ersetzt werden könnten, sondern direkt auch die innovative Spezialsoftware, die vermeintlich die Ingenieur:innen ersetzt, durch allgemeine große Sprachmodelle.

Als Vorstandsmitglied der Planungsgruppe TMM AG, mit der ich beruflich groß geworden bin und die ich liebe, und als CTO des ConTech Unternehmens DBI AG („berta & rudi“), welches zurzeit all meine professionelle Leidenschaft konsumiert, muss ich mich aktuell leider mit beiden Aspekten dieser steilen Eingangsthese befassen. Und ganz offen: Mir hätte die Paranoia, bezogen auf ein Unternehmen, gereicht.

Kurzfassung: Beides ist ernst zu nehmen. Für uns Menschen bedeutet es im Wesentlichen, dass Mittelmaß nicht mehr ausreicht (hier wird die KI eher früher als später bei mehr Effizienz adäquate Ergebnisse liefern). Es gilt also nach Außergewöhnlichem zu streben. Für einen tieferen Einblick kommt man leider um einen kleinen Deep Dive nicht drum herum.

Vorab etwas Kontext, warum der folgende Meinungsbeitrag so ist, wie er ist: Über Weihnachten und Neujahr ist, wie für viele anderen auch, die Zeit, um sich Gedanken über das kommende Jahr zu machen. Manchmal finden diese Gedanken ihren Weg in einer Art „Neujahrsbrief“ zu den Kolleg:innen. Dieses Jahr habe ich mich dazu entschieden, die Gedanken in einem etwas größeren Kreis zu teilen, weil das für mich kein unternehmensspezifisches Thema ist, sondern ein universelles.

Wie viel Substanz steckt hinter dem KI Hype?

Vor zwei Jahren war ein Thema für den Neujahrsbrief unumgänglich: GPT 3.5 hat KI in den Mainstream gebracht und seitdem einen nachhaltigen Hype ausgelöst. Aber wo stehen wir jetzt? Wie viel Substanz ist hinter dem Hype?

Also, Substanz war immer da. Technologisch sind die Entwicklungen der letzten zwei Jahre nach wie vor beeindruckend. Dennoch hätte ich noch vor drei Monaten an dieser Stelle vor allem über Ernüchterung geschrieben.

Wäre da nicht die Ankündigung (und die ersten Benchmark-Ergebnisse) von GPT o3… Klar, der Hype ist abermals groß und es ist viel Marketing im Spiel. Aber es ist mehr als das.

ChatGPT o3

Zurück zu o3. Was ist passiert? Ende 2024 kündigt OpenAI das Model o3 an, welches wie sein Vorgänger o1 vor allem durch die Fähigkeit von „logischem Denken“ punkten soll, d.h. anstatt das erstbeste Ergebnis auszuspucken, durchläuft das Modell in einer sogenannten Chain of Thought einen schrittweisen „Denkprozess“ („Reasoning“), erzeugt im Hintergrund selbstständig mehrere Lösungswege, entscheidet sich für einen und gibt am Ende eine wesentlich bessere Antwort als ChatGPT 3.5 bzw. 4. Dies jedoch zu Lasten von mehr Rechenkapazität.

Was hatten wir vor den "Reasoning"-Modellen o1 bzw. o3?

Und in der Tat fand ich bereits o1 sehr beindruckend. Ein bisschen Hintergrund: Alle paar Monate versuche ich (mit Schweißperlen auf der Stirn) das, was wir mit berta & rudi machen, mit ChatGPT umzusetzen – also Energiekonzepte. Auch GPT-4 brachte da auf den ersten Blick keine schlechten Ergebnisse. Aber es war auch schnell offensichtlich, dass keine bewusste Vorgehensweise hinter den Ergebnissen stand. Es wird halt einfach angenommen, dass beispielsweise ein BHKW für ein bestimmtes Stadtquartier eben 350 MWh Strom und 600 MWh Wärme produziert, zusätzlich zu einem Gaskessel mit ca. 350 MWh, und die Erzeuger beide zusammen 125.000 € kosten, bei ca. 200.000 € Energie- und Betriebskoten. Ganz einfach, weil das häufig so gebaut wurde, das BHKW in der Regel einen gewissen Anteil an der Wärme hat etc. Nicht schlecht, aber auch nicht wirklich hilfreich. Insbesondere wenn man neben all den anderen Schwächen, die das Ganze so mit sich bringt, bedenken muss, dass eben keine bewusste Vorgehensweise zugrunde lag – also beispielsweise als Erstes die Nutzenergie zu berechnen und dann erst das Energiesystem auszulegen. Neben ganz vielen Gründen, warum das nicht gut ist, geht’s schon allein um die Vergleichbarkeit von Varianten. Also eher meh…

Dann kam ChatGPT o1…

ChatGPT o1 hat plötzlich genau das gemacht, also insbesondere ungefragt (!) gemacht, denn auch GPT-4 hätte man zu einem schrittweisen Vorgehen hin prompten können. o1 hingegen haut infolge eines zehnzeiligen Prompts nicht nur drei (nicht von der Hand zu weisende) Varianten raus, sondern liefert auch eine genaue Herleitung, wie die Ergebnisse zustande kommen, also Nutzenergiebedarfe, Variantendefinition und Auslegung, Berechnung und Wirtschaftlichkeitsbewertung. Und dann war das Ganze sogar ziemlich dicht an den Ergebnissen von berta & rudi. „Ziemlich dicht“ meint übrigens eine Abweichung von ca. 50 % und ist nicht wenig, aber gemessen daran, dass es aus dem Nichts kam, definitiv nicht wertlos. Also erstmal uff… (Wars das für berta & rudi?) Bei wiederrum genauerer Betrachtung fallen aber wieder klare Grenzen und altbekannte Probleme auf: fehlende Nachvollziehbarkeit, starke Vereinfachung der Berechnung, inkonsistente Annahmen, „Vergessen“ von zuvor gegebenen nutzerspezifischen Angaben im Laufe des Dialogs und vor allem eine nur sehr begrenzte Anpassbarkeit der Ergebnisse. Und sobald es komplexer wird, d.h. wo die Datenlage nicht so groß und öffentlich ist (Industrie) oder man Neuland betritt (dynamische Strompreise, Speicher, Wasserstoff etc.) wird es völlig wild und unbeherrschbar. Also in jedem Fall immer noch nur dann gut, wenn man Dinge plant, die schon vielfach so oder so ähnlich geplant wurden.

Was macht o3 nun so besonders?

Also, erstmal ist das Modell noch nicht für die Öffentlichkeit zugänglich (kommt wohl irgendwann im Q1/25). Daher konnte ich meine Berechnung noch nicht in o3 testen und ich kann mich nur darauf stützen, was an öffentlichen Informationen verfügbar ist. Und bevor wir tiefer einsteigen, muss ich an der Stelle nochmal betonen, dass bei dem ganzen Zeug extrem viel Marketing im Spiel ist, das heißt: alles ist mit sehr großer Vorsicht zu genießen. Dennoch sind die Ergebnisse auch wissenschaftlich und technisch höchst interessant und waren bis vor kurzem eher undenkbar. Auch nehme ich mir im Folgenden nur einen von vielen Aspekten heraus, die in dem Zusammenhang allesamt höchst interessant sind. Aber der Aspekt steht für mich recht repräsentativ, was für faszinierende Entwicklungen aktuell in dem Bereich passieren.

Und zwar wurden im Zuge der Vorstellung von o3 diverse Benchmarks durchgeführt und die Ergebnisse präsentiert. Einer davon ist das AGI Benchmark ARC. Wichtig an dem Benchmark ist eben der nach wie vor nicht allgemeingültig definierte Begriff AGI.

Exkurs: Meine Definition von AGI halte ich nach wie vor kurz: Wenn wir AGI erreichen, werden wir es merken, weil wir dann nicht mehr darüber diskutieren. Dass das G in AGI jedoch für Generalisierung steht, ist hingegen für das folgende Verständnis äußerst relevant, da es impliziert, dass ein Modell nicht einfach über große Datenmengen zu allen Wissensdisziplinen trainiert wurde, sondern sich viele Dinge selbstständig erschließen oder aus anderen Bereichen ableiten kann.

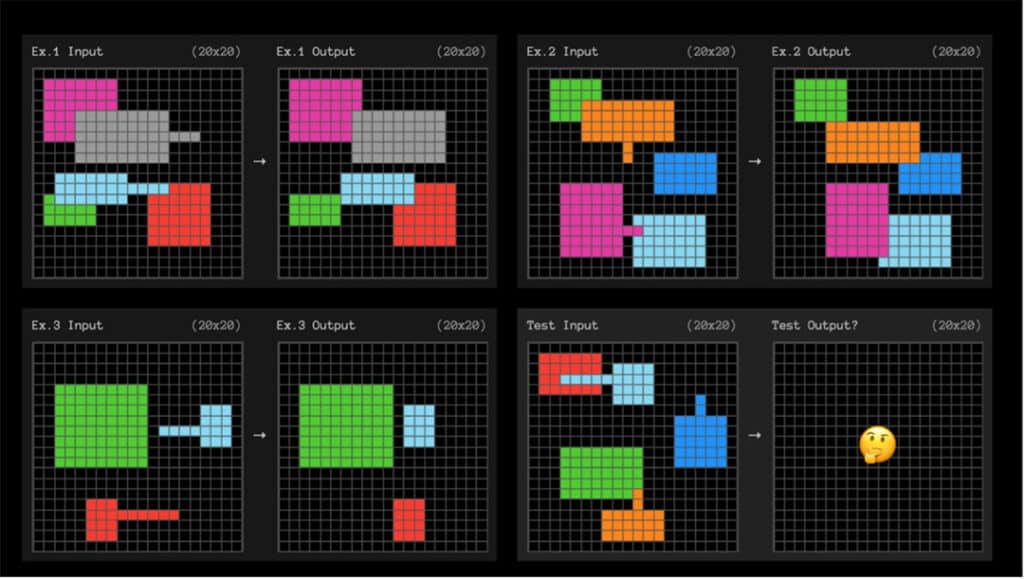

Aus Sicht des AGI Benchmark ARC ist die Definition aber dann doch nicht so entscheidend, sondern vor allem der bloße Aspekt, dass es eben darum geht, Aufgaben zu lösen, die eine gewisse Art von „Schlussfolgern“ (wie auch immer man das für sich definiert) erfordern und vor allem dem Modell zuvor nicht bekannt waren, das heißt in der konkreten Ausprägung nicht Teil der Trainingsdaten waren. So sieht ein Rätsel zum Beispiel aus:

(Quelle: ARC)

o3 wurde in unterschiedlichen Ausprägungen (im Wesentlichen unterschiedliche Rechenkapazitäten) getestet und hatte im besten Fall 87,5 %. GPT-4o hatte nicht einmal 10 %, o1 erreichte bestenfalls 32 %. Also definitiv beeindruckend!

Dennoch gibt es Besonderheiten. Für uns Menschen sind diese Rätsel auch dann einfach, wenn wir noch nie zuvor vergleichbare Aufgabenstellungen gesehen haben. Das Modell o3 musste jedoch zuvor nach Aussagen von OpenAI mit ähnlichen Aufgaben trainiert werden, und zwar der öffentliche Teil des Datensatzes von AGI Benchmark ARC. Also auch o3 findet wie seine Vorgänger keinen „intuitiven“ Zugang zu der Aufgabenstellung. Das Modell könnte ohne, dass vergleichbare Aufgaben Teil der Trainingsbasis waren, wahrscheinlich nichts mit den Rätseln anfangen.

Wir müssen nun für das folgende Verständnis leider ganz kurz noch etwas tiefer rein gehen, auch wenn ich vieles auslasse. Außerdem wird es recht spekulativ, weil nicht öffentlich ist, wie o3 genau funktioniert. Es liegt aber nahe, dass es zumindest prinzipiell nach dem Konzept „Test-Time-Training“ (https://arxiv.org/abs/2411.07279) funktioniert.

Wendet man die Hintergründe dieses Konzepts auf die Ergebnisse von o3 im AGI Benchmark ARC an, muss man sich zunächst nochmal vor Augen führen, dass Transformer LLMs, wie es GPT in jeder Form ist, vor allem auf große Datenmengen angewiesen sind. Da das bezogen auf den AGI Benchmark ARC – so ist es anzunehmen – nicht der Fall ist, macht die Ergebnisse eben so besonders. Wie löst o3 dieses Problem also? Es liegt also mit dem Konzept im Hinterkopf nahe, dass das Modell die Beispielaufgaben zunächst vervielfältigt und dabei nach Regeln verändert, also bspw. rotiert, gespiegelt etc., um so die Datenmenge künstlich zu erhöhen. Letztlich wird das Modell „ge-finetuned“, also eigentlich sogar mehrere Modelle, aber das ist gerade nicht entscheidend. Zur Inferenz (also in dem Moment, in dem das Modell bzw. die Modelle die eigentliche Aufgabe lösen soll), werden alle (also auch die vervielfältigten) Varianten berücksichtigt. Daraus entstehen dann verschiedene Lösungswege, von denen dann nach einer bestimmten Logik eine (oder auch mehrere) Lösung ausgewählt wird. Ich finde diesen Vorgang deshalb so faszinierend, weil das Spiegeln und Rotieren für uns Menschen tendenziell gar keinen Erkenntnisgewinn bringen würde, aber in diesem Fall scheint es der Schlüssel zu sein.

Das könnte übrigens auch der Grund sein, warum o3 in dem Benchmark so wahnsinnig rechenintensiv war. Tatsächlich soll die Beantwortung der 400 Aufgaben durch o3 in der potentesten Version über 1 Mio. € gekostet haben. Das ist übrigens auch der aktuelle Aufhänger der meisten Diskussionen, also dass sich das ja niemals rechnen könne etc. (Spekulationen reichen bis zu mehreren Tausend $ oder sogar Zehntausend $ pro Anfrage etc.) Und ja, es wird definitiv teurer, denke ich, aber es wird auch wieder billiger, wenn die Technik weiter voranschreitet. In jedem Fall finde ich, dass es überhaupt funktioniert, ist die wesentlich größere Nachricht!

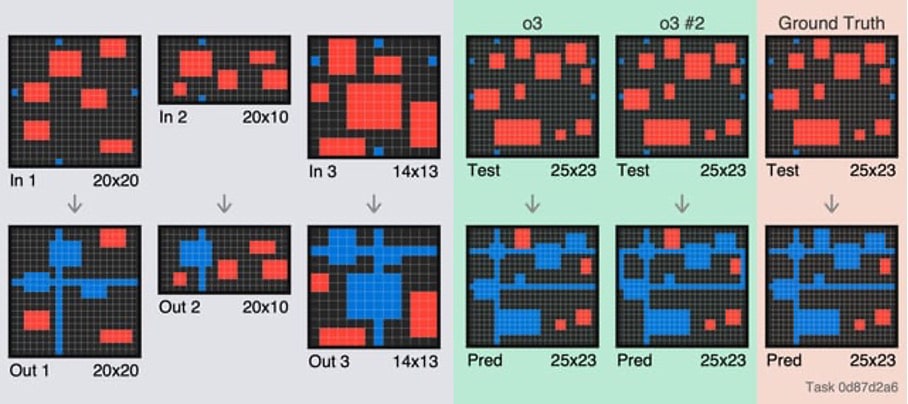

Trotz der Euphorie sagt uns das aber auch ein bisschen was über die „Denkweise“ (ihr versteht mittlerweile, warum ich das ständig in Anführungszeichen setze) von o3. So ist es nicht erstaunlich, dass o3 weiterhin sehr einfache Aufgaben falsch beantwortet, bspw.:

(Quelle: ARC)

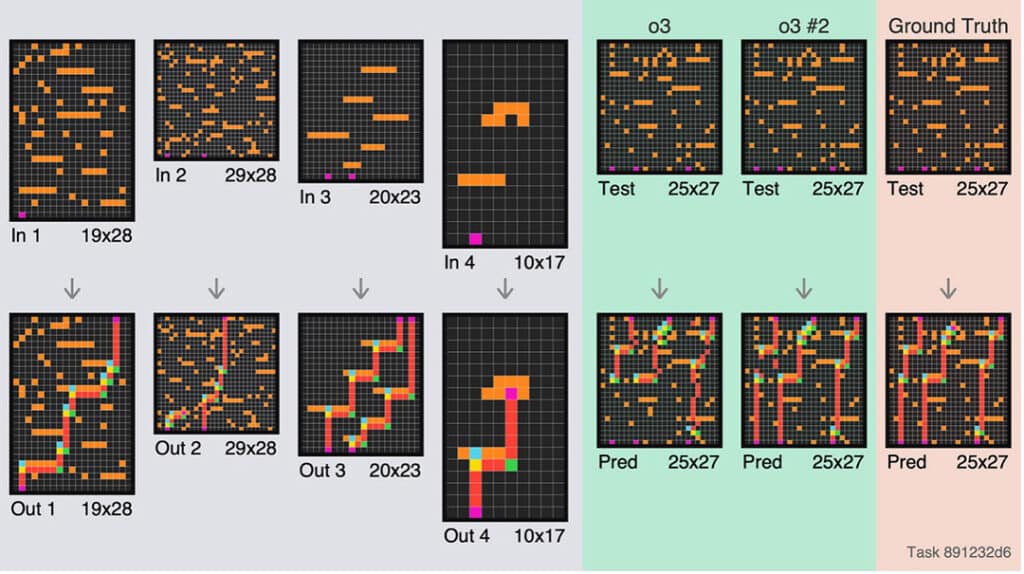

Na gut, um fair zu sein, hätte ich die Aufgabe genauso falsch beantwortet. Konkret hätte ich exakt dieselbe falsche Antwort gegeben wie o3 in seinem ersten Versuch. Aber spätestens bei dem folgenden Beispiel wird dann deutlich, dass es eben auch irritierend falsch sein kann:

(Quelle: ARC)

Irritierend deshalb, weil es scheinbar sehr unwillkürlich ist.

Was hat das mit irgendeinem realen Problem zu tun?

Zunächst mal nicht viel. Aber es geht eben nicht um die Problemart, sondern darum, dass logische Denkaufgaben ohne große Datenbasis gelöst werden konnten. Das ist definitiv eine große Sache! Zusammengefasst fallen folgende Dinge auf:

- LLMs (GPT) wird nachgesagt, dass sie keine echte Logik können. Ich denke auf Basis der vorherigen Ausführungen auch, dass da immer noch kein echtes Verständnis dahinterliegt. Aber das scheint gar nicht schlimm zu sein! „Whatever works!“ Wir dürfen KI nicht danach bewerten, ob sie „denken“ kann, sondern welchen Nutzen sie stiftet.

- Es konnte gezeigt werden, dass auch bei LLMs, Daten nicht unbedingt der Engpass sein müssen, auch wenn es um Logik geht. Wenn Daten fehlen, gibt es Mechanismen, diese aufzufüllen. Das wiederrum könnte besonders relevant werden, wenn uns AI Agenten (also virtuelle Assistenten im Alltag) begleiten, die dann mit relativ wenig Daten Dinge von uns lernen und zukünftig selbst erledigen könnten.

- Wenn man den Rechenaufwand in den Griff kriegt, wird das alles definitiv zeitnah etwas verändern!

Wie stark sich das alles dann in realen Problemen äußert, werden wir erst mit dem Release von o3 lernen.

Aber bezogen auf unseren Arbeitsbereich als Ingenieurbüro muss man sich nur mal vorstellen, dass so ein Modell dann eben beispielsweise trotz fehlender Datenbasis vielleicht doch ganz gut Trassenführungen lernen kann (so ein Gebäude kann man auch drehen, spiegeln etc.), was Stand heute immer noch eher durch klassische Optimierungsverfahren gelöst wird (auch wenn eigentlich immer „KI“ draufsteht).

Ich gehe mittlerweile davon aus, dass KI uns bei wesentlich mehr Aufgaben unterstützen beziehungsweise sogar ersetzen wird als, ursprünglich angenommen.

Es bleibt viel Ungewissheit. Gibt es etwas, dass man sich als Ingenieurbüro jetzt schon mitnehmen kann?

Auf jeden Fall! Es zeigt mir einmal mehr, dass wir als Ingenieurbüro und Softwareunternehmen nicht versuchen sollten mit KI zu konkurrieren. Heißt konkret: Wir müssen das ausspielen, was uns ausmacht, und zwar unsere Menschlichkeit! Wenn wir Menschen uns als kleine Maschinen betrachten, haben wir schon verloren.

Ein weiterer Aspekt ist etwas, dass ich nicht müde werden zu betonen: Mittelmäßigkeit ist nicht genug. In Aufgaben, die lediglich Mittelmaß erfordern, wird uns KI eher früher als später überlegen sein. Also, seid mutig und außergewöhnlich! Was das genau bedeutet, ist jedem selbst überlassen. Sei außergewöhnlich, weil du der größte Fachmann in deinem Gebiet bist. Sei außergewöhnlich, indem du selbst den schwierigsten Kunden wieder einfängst. Sei außergewöhnlich, indem du das Team selbst in den stressigsten Zeiten zusammenhältst. Suchs dir aus! Aber sei niemals mit dem Mittelmaß zufrieden!

Und um die Brücke zum Anfang zu schlagen: Wird o3 berta & rudi ersetzen können?

Ich denke nicht, dass wir durch o3 ersetzt werden, kann aber nicht ausschließen, dass es durch eine zukünftige GPT-Version passieren könnte. Also auch hier müssen wir schnell und adaptiv sein.